Gepostet von willcritchlow in Online Marketing Tools

Im echten Leben gehen manche Dinge schief. Obwohl wir uns wünschen, dass alles, was wir gemacht haben, nach dem Schema „einmal gemacht, nie mehr daran gedacht“ verläuft, ist dies nur selten der Fall.

Dinge, die zuvor noch kein Problem waren, können sehr schnell aus verschiedensten Gründen zu einem Problem werden.

- Jemand verändert etwas Unzusammenhängendes, ohne wahrzunehmen, dass es Sie beeinflussen oder einfach alles versauen würde (z. B. eine noch nicht fertige Version der robots.txt verwenden oder eine alte Version einer Server-Konfiguration)

- Die Welt um Sie herum verändert sich. (Es gab kürzlich ein Google-Update, das nach einem schwarz-weissen Tier benannt wurde)

- Die rätselhaften, technischen Fehler verbünden sich gegen Sie. (Server-Offlinezeit, DDoS usw.)

In all diesen Fällen sollten Sie lieber vorzeitig über dieses Problem Bescheid wissen als später, weil Ihre Fähigkeit, die resultierenden Schwierigkeiten zu minimieren, in den meisten Fällen mit der Zeit rapide abnehmen (und in den übrigen Fällen wollen Sie es immer noch vor Ihrem Chef oder Kunden wissen).

Wenngleich viele von uns zu der Idee kamen, dass wir Empfehlungen in diesen Bereichen aussprechen sollten, sind wir dennoch dabei, auf eindrucksvolle Weise unnütze Ratschläge zu erteilen, wie z. B.:

- Stellen Sie sicher, dass Sie eine grossartige Uptime haben.

- Stellen Sie sicher, dass Ihre Seite schnell ist.

Heute will ich Ihnen drei direkt anwendbare Ratschläge mitgeben, die Sie für Ihre eigene Seite und Ihre Kernkunden gebrauchen können. Diese Tipps werden Ihnen dabei helfen, Probleme vorzeitig aufzudecken, Kettenreaktions-Indexierungsprobleme zu vermeiden und schnell vor schlechten Anwendungen gewarnt zu werden, welche Ihre Suchperformance beeinträchtigen könnten.

1 Rückgang von Traffic

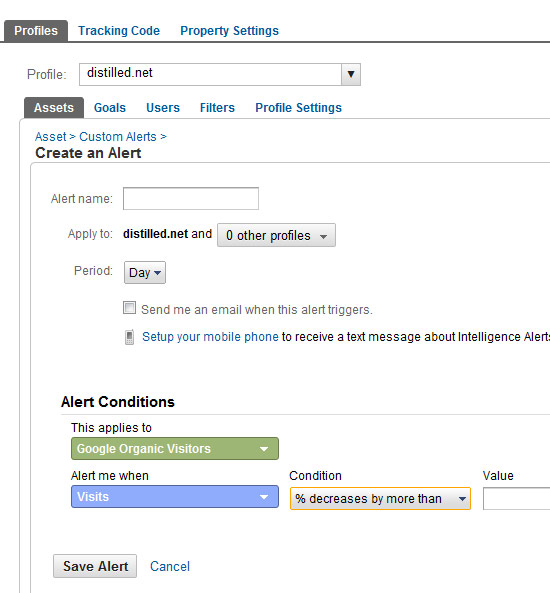

Google Analytics beinhaltet ein Feature, welches beträchtliche Veränderungen im Traffic oder in dessen Profil erkennt. Es kann Sie auch warnen. Das erste dieser Features nennt sich „intelligence“ und das zweite „intelligence alerts“.

Google Analytics beinhaltet ein Feature, welches beträchtliche Veränderungen im Traffic oder in dessen Profil erkennt. Es kann Sie auch warnen. Das erste dieser Features nennt sich „intelligence“ und das zweite „intelligence alerts“.

Anstelle des Wiederkäuens alter Ratschläge werde ich Ihnen die Links zu den zwei besten Einträgen, die ich über dieses Thema gelesen habe, angeben:

- Bei SEOmoz von Rebecca Lehmann – 7 essentielle Google intelligence custom alerts

- Auf Blueglass von Annie Cushing – Bleiben Sie alarmiert mit Google Analytics

Das ist die am einfachsten anwendbare Empfehlung und gleichzeitig die ganzheitlichste im Sinne dessen, dass sie Sie dann warnen kann, wenn Rückgange von Traffic zu verzeichnen sind. Der Nachteil daran ist natürlich jener, dass Sie nur Symptome, nicht jedoch die Ursachen behandeln, weshalb Sie

a) auf Ursachen warten müssen, die Symptome hervorrufen, anstatt vor dem Problem an sich gewarnt zu werden und

b) Sie einen Alarm über das Symptom anstatt über den Grund erhalten und mit Detektivarbeit beginnen müssen, bevor Sie eine Person kontaktieren können, die das Problem lösen kann.

2 Uptime-Überwachung

Man braucht kein Raketenwissenschaftler zu sein, um festzustellen, dass SEO von Ihrer Webseite abhängt. Sie ist nicht nur davon abhängig, wie Sie Ihre Seite optimieren, sondern auch davon, dass die Seite verfügbar ist.

Bei grösseren Kunden sollte es nicht Ihre Aufgabe sein, jemanden zu alarmieren, wenn deren Webseite abstürzt, jedoch schadet es nicht, es zu wissen. Bei kleineren Kunden besteht eine hundertprozentige Chance, dass Sie für wichtigen Wert sorgen würden, indem Sie ein Auge auf solche Dinge werfen.

Ich kenne sowohl gute als auch schlechte Gründe, wieso man viel über Server-Überwachung wissen soll:

- Die guten Gründe: Wir tätigten eine kleine Investition in Server Density im Mai letzten Jahres (und bewerteten unseren einzigen Link von Techcrunch in diesem Prozess).

- Die schlechten Gründe: Wir waren enthusiastischere User unserer Dienstleistungen der Portfolio-Firma, als wir es gehofft hatten – einige nervige Serverprobleme haben zu längeren Offline-Zeiten bei destilled.net geführt. Um das Ganze noch schlimmer zu machen, schafften wir es, letzte Woche von einer DDoS-Attacke getroffen zu werden (siehe Grafik unten).

Es gibt drei Hauptelemente, die Sie überwachen wollen:

- Völlige Zugänglichkeit (inklusive Antwort-Code)

- Serverladezeiten und Leistung

- Antwortgeschwindigkeit/Seitenladezeit

Verfügbarkeit der Webseite

Es gibt hier zwei Dienstleistungen, die ich empfehle:

- Pingdoms gratis Service überwacht die Verfügbarkeit und die Antwortzeit Ihrer Webseite.

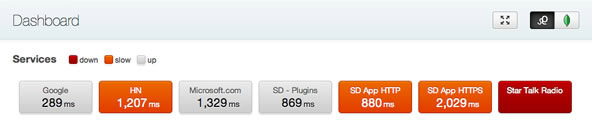

- Server Densitys bezahlter Service bietet griffigeres Alarmieren und bessere Grafiken. Zudem wird die Serverleistung überwacht.

So sieht das Dashboard von Server Density aus:

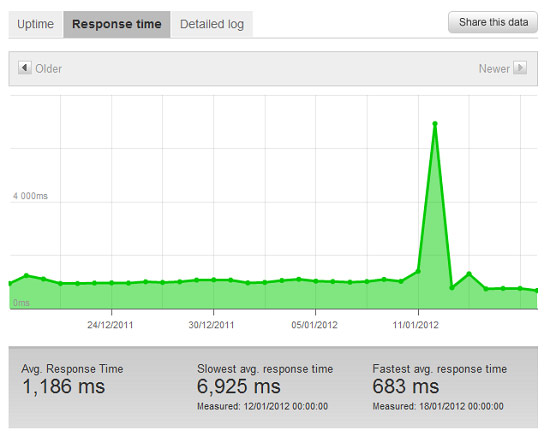

Und hier sehen Sie das Antwortzeit-Diagramm von pingdom:

Und hier sehen Sie das Antwortzeit-Diagramm von pingdom:

Sie erkennen die Spitze in der Antwortzeit während der DDoS-Attacke und die niedrigere, durchschnittliche Antwortzeit während der letzten Tage, nachdem wir cloudflare implementierten.

Sie erkennen die Spitze in der Antwortzeit während der DDoS-Attacke und die niedrigere, durchschnittliche Antwortzeit während der letzten Tage, nachdem wir cloudflare implementierten.

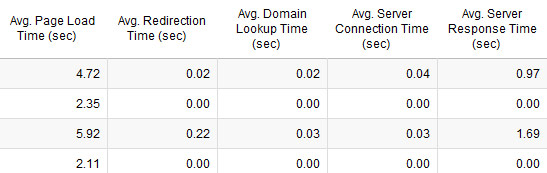

Übrigens könnten Sie verpasst haben (es ist an mir vorbeigegangen, bis Mike mir neulich die Vorwarnung gab), dass Google die Seitengeschwindigkeiten allen Analytics-Accounts ohne die zuvor benötigten Veränderungen des GA-Auszugs aufzeigte, weshalb man jetzt etwas von diesen Daten über den GA-Account erhält. Hier sehen Sie den technischen

Zusammenbruch einiger Seiten von Distilled:

3 Robot-Ausschluss-Protokolle, Status-Codes

Das war die ambitionierteste meiner Ideen für das Überwachen der SEO. Sie entstand aus einem Problem mit einem Kunden. Ein Hauptkunde brachte eine neue Webseite heraus und schaffte es, eine alte/unfertige Version von robots.txt am Sonntagmorgen (fortwährende Integration FTW) anzuwenden. Es war wirklich Glück, dass die SEO, die das Projekt zum Laufen brachte, überall vorhanden war, die Seite schnell aufspürte, den Kernkontakt kontaktierte und die Webseite aufhielt, bevor längerfristiger Schaden entstehen konnte. Wir hatten eine Nachbesprechung in der darauffolgenden Woche, bei der wir darüber diskutierten, wie wir automatisch über diese Dinge in Kenntnis gesetzt werden könnten.

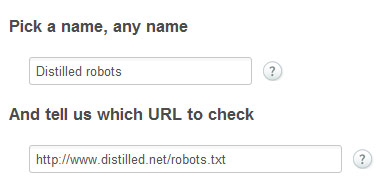

Ich wandte mich an David Mytton, den Gründer von Server Density, und fragte ihn, ob er einige Features einbauen könnte, falls solche Sachen geschehen – falls wir zufällig unsere Seite „noindexen“ oder sie in der robots.txt-Datei blockieren. Er kam zu dieser genialen Lösung, die Funktionaltäten verwendet, die bereits in deren Kernplattform verankert waren.

Jede Veränderung von robots.txt überwachen

Erstellen Sie zuerst ein Service, um die robots.txt-Datei zu überwachen – Hier ein Beispiel:

Dann erstellen Sie einen Alarm, der Ihnen sagt, ob sich die MD5-hash der Inhalte auf robots.txt verändern (hier sehen Sie eine Definition der MD5):

Dann erstellen Sie einen Alarm, der Ihnen sagt, ob sich die MD5-hash der Inhalte auf robots.txt verändern (hier sehen Sie eine Definition der MD5): Wenn Sie die Inhalte Ihrer robots.txt-Datei in einen MD5-Generator kopieren und einfügen, erhalten Sie viel Kauderwelsch (unseres ist „15403cbc6e028c0ec46a5dd9fffb9196“). Dieser Alarm überwacht jegliche Veränderung Ihrer robots.txt. Wenn wir also eine neue Version anwenden, werde ich eine E-Mail und eine Benachrichtigung auf mein Handy bekommen. Wäre es nicht nett, einen solchen Alarm zu bekommen, wenn ein Kunde oder ein dev-Team ein Update auf robots.txt bringen würde, ohne es Ihnen zu sagen?

Wenn Sie die Inhalte Ihrer robots.txt-Datei in einen MD5-Generator kopieren und einfügen, erhalten Sie viel Kauderwelsch (unseres ist „15403cbc6e028c0ec46a5dd9fffb9196“). Dieser Alarm überwacht jegliche Veränderung Ihrer robots.txt. Wenn wir also eine neue Version anwenden, werde ich eine E-Mail und eine Benachrichtigung auf mein Handy bekommen. Wäre es nicht nett, einen solchen Alarm zu bekommen, wenn ein Kunde oder ein dev-Team ein Update auf robots.txt bringen würde, ohne es Ihnen zu sagen?

Die Einbeziehung von no-index Meta-Tags herausfinden

Auf ähnliche Art und Weise können Sie Alarme für spezifische Textteile von spezifischen Seiten erstellen – Ich habe mir ausgesucht, alarmiert zu werden, wenn die Zeile „noindex” in der HTML der Distilled-Homepage auftaucht. Falls wir jemals eine noch nicht fertige Version herausbrächten oder eine Einstellung in einem WordPress-Plugin veränderten, würde ich sofort eine Benachrichtigung erhalten:

Diese Art der Überwachung ist für mich gratis, da wir Server Density bereits dazu verwendeten, die Gesundheit unserer Server zu überwachen, weshalb es keine zusätzliche Anstrengung ist, Kontrollsummen und die Anwesenheit/Abwesenheit spezifischer Textzeilen zu prüfen.

4 Bonus – Wieso jetzt aufhören?

Sehen Sie sich all die Dinge an, die etsy überwacht. Wenn Sie ein Team haben, das die Plattform/Infrastruktur bauen kann, dann gibt es quasi kein Limit für die Dinge, die Sie überwachen können und für die Sie einen Alarm erstellen können. Hier sind ein paar Denkanstösse:

- Status-Codes – 404 vs 301 vs 302 vs 500 usw.

- Veränderungen in den Konversionsraten/Abbrüchen

- Bot-Verhalten – Muster suchen usw. – angesichts dessen, wie unproportional interessiert ich an der einfachen „Seiten gecrawled“-Visualisierung war, die in cloudflare verfügbar ist. (sehen Sie unten: wer hätte gedacht, dass wir öfter von Yandex als von Google besucht würden?). Ich denke, dass hier noch mehr getan werden könnte:

Quelle: seomoz.org